대역폭은 비디오 감시 시스템을 위한 이더넷 네트워킹의 가장 중요한 요소입니다. 사전에 주의 깊게 계획하지 않으면 비디오 감시 시스템에 대역폭 병목 현상이 발생할 수 있습니다. 이로 인해 비디오 패킷 손실, 지연 또는 지터가 발생할 뿐만 아니라 비디오 품질이 저하되거나 심각한 사건의 녹화가 금지됩니다. 대역폭은 또한 주어진 보존 기간에 대한 스토리지 용량 요구 사항을 결정합니다. 비디오 대역폭을 이해하려면 여러 분야에 대한 심층적인 지식이 필요합니다. 이 기술 노트는 비디오 감시 시스템 성능에 영향을 미치는 요소에 대한 기본 지식을 제공하기 위해 인턴되었습니다.

대역폭이란 무엇입니까?

IP 비디오 카메라의 이미지, 오디오 및 제어 데이터를 포함하는 데이터 스트림으로 전송됩니다. 초당 보내야 하는 데이터의 양을 대역폭이라고 합니다. 일반적으로 Mbit/s 단위로 측정되므로 이더넷 링크의 비트 전송률 용량과 쉽게 비교할 수 있습니다. 예를 들어 10Mbit/s는 이더넷, 100Mbit/s는 패스트 이더넷, 1,000Mbit/s는 기가비트 이더넷입니다. 또 다른 측정 단위는 MByte/s로 1바이트에 8비트가 있기 때문에 비트 전송률의 8/XNUMX과 같습니다.

1Mbit/s = 1,000Kbit/s = 125Kbyte/s

1Gbit/s = 1,000Mbit/s = 125Mbyte/s

1920 x 1080 HD 해상도 카메라는 대략 1.49 FPS 비디오에 대해 30 Gbit/s(1920 x 1080 x 24 x 30)의 원시 비디오 데이터를 생성합니다. 이는 178MByte/s의 데이터와 비디오 압축이 필요한 이유입니다.

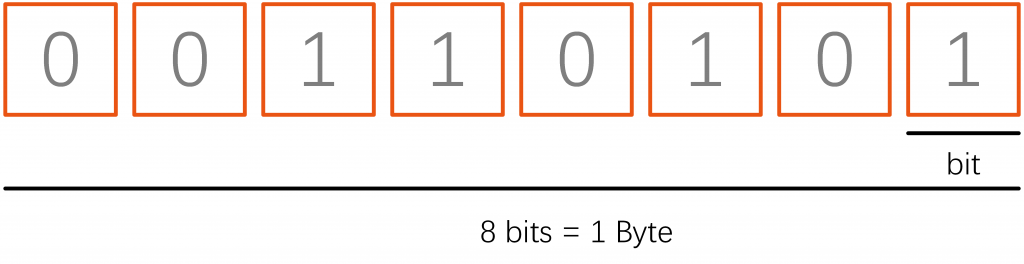

비트 및 바이트

비디오 감시 시스템에서 대역폭은 일반적으로 비트 단위로 측정되지만 때때로 바이트 단위로 측정되어 혼란을 야기합니다. 8비트는 1바이트이므로 초당 40메가바이트라고 말하는 사람과 초당 5메가바이트라고 말하는 사람은 같은 의미이지만 오해하기 쉽습니다.

비트와 바이트는 속기 참조를 위해 동일한 문자를 사용합니다. 유일한 차이점은 비트는 소문자 'b'를 사용하고 바이트는 대문자 'B'를 사용한다는 것입니다. 바이트가 비트보다 '더 크다'는 것을 기억하면 이것을 기억할 수 있습니다. 우리는 사람들이 얼핏 보기에 비슷해 보이기 때문에 종종 이것을 혼동하는 것을 봅니다. 예를 들어 100Kb/s 및 100KB/s의 경우 후자는 전자보다 8배 더 큽니다.

비디오 감시 시스템 대역폭을 설명할 때 비트를 사용하는 것이 좋지만 종종 서버/스토리지 측에서 일부 사람들이 바이트를 사용한다는 점에 유의하십시오. 따라서 명확하지 않은 부분이 있으면 주의를 기울이고 확인을 요청하십시오(예: "X비트 또는 바이트라고 말씀하셨습니까?").

킬로비트, 메가비트 및 기가비트

비디오를 전송하려면 많은 비트(또는 바이트)가 필요합니다. 실제로는 500b/s 또는 500B/s의 비디오 스트림을 가질 수 없습니다. 비디오는 일반적으로 최소 수천 또는 수백만 비트가 필요합니다. 집계된 비디오 스트림에는 종종 수십억 비트가 필요합니다.

많은 양의 대역폭을 표현하기 위한 일반적인 표현/접두사는 다음과 같습니다.

- 킬로비트는 수천입니다. 예를 들어 500Kb/s는 500,000b/s입니다. 킬로비트 단위의 개별 비디오 스트림은 저해상도, 저프레임 또는 고압축(또는 위의 모든 것)인 경향이 있습니다.

- 메가비트는 수백만입니다. 예를 들어 5Mb/s는 5,000,000b/s입니다. 개별 IP 카메라 비디오 스트림은 한 자릿수 메가비트(예: 1Mb/s 또는 2Mb/s 또는 4Mb/s가 상당히 일반적인 범위임)인 경향이 있습니다. 초고해상도 모델(10K, 4MP, 20MP 등)에서 불가능한 것은 아니지만 개별 비디오 스트림에 대해 30Mb/s 이상은 일반적이지 않습니다. 그러나 동시에 스트리밍되는 100대의 카메라는 일상적으로 200Mb/s 또는 300Mb/s 등을 요구할 수 있습니다.

- 기가비트는 수십억입니다. 예를 들어 5Gb/s는 5,000,000,000b/s입니다. 모든 비디오를 중앙 사이트로 백홀링하는 대규모 비디오 감시 시스템이 없는 한 비디오 감시에 기가비트 이상의 대역폭이 필요한 경우는 거의 없습니다.

비트 레이트

Ivideo 감시 시스템 대역폭은 차량 속도와 같습니다. 시간 경과에 따른 비율입니다. 따라서 60mph(또는 96kph)를 운전하고 있다고 말하는 것처럼 카메라의 대역폭이 600Kb/s라고 말할 수 있습니다. 즉, 600초에 XNUMX킬로비트가 전송되었다고 말할 수 있습니다.

비트 전송률은 항상 XNUMX초 동안의 데이터(비트 또는 바이트)로 표현됩니다. 주로 네트워킹 장비는 장치가 초당 처리할 수 있는 것으로 평가되기 때문에 분당 또는 시간당은 적용할 수 없습니다.

비디오 압축 및 대역폭

비디오 감시 시스템의 비디오 압축은 원본 파일보다 적은 공간을 사용하고 네트워크/인터넷을 통해 더 쉽게 전송할 수 있도록 비디오 파일을 인코딩하는 프로세스입니다. 원본 비디오 파일에서 중복되고 비기능적인 데이터를 제거하여 비디오 파일 형식의 크기를 줄이는 일종의 압축 기술입니다.

비디오가 압축되면 원본 형식이 사용된 코덱에 따라 다른 형식으로 변경됩니다. 비디오 플레이어는 비디오 파일을 재생하기 위해 해당 비디오 형식을 지원하거나 압축 코덱과 통합되어야 합니다.

모션 JPEG

Motion JPEG(M-JPEG 또는 MJPEG)는 비디오 압축 형식 각각 비디오 프레임 or 인터레이스 필드 디지털 비디오 순서는 압축 된 별도로 JPEG 영상.

원래 멀티미디어 PC 응용 프로그램용으로 개발된 Motion JPEG는 광범위한 클라이언트 지원을 제공합니다. 대부분의 주요 웹 브라우저와 플레이어는 기본 지원을 제공하고 나머지는 플러그인을 사용할 수 있습니다. M-JPEG 표준을 사용하는 소프트웨어 및 장치에는 웹 브라우저, 미디어 플레이어, 게임 콘솔, 디지털 카메라, IP 카메라, 웹캠, 스트리밍 서버, 비디오 카메라 및 비선형 비디오 편집기가 포함됩니다.

MPEG-264 AVC라고도 하는 H.4는 2003년에 도입된 압축 표준이며 비디오 감시 시스템 카메라 및 많은 상용 미디어 응용 프로그램에 널리 사용되는 표준입니다. MJPEG의 프레임 단위 접근 방식과 달리 H.264는 풀 프레임을 XNUMX초에 한 번 등의 간격으로만 저장하고 나머지 프레임은 비디오의 움직임으로 인한 차이만 인코딩합니다. 전체 프레임은 I-프레임(인덱스 프레임 또는 인트라 프레임이라고도 함)이라고 하며 이전 프레임과의 차이만 포함하는 부분 프레임을 P-프레임(예측 프레임 또는 인터 프레임이라고도 함)이라고 합니다. P-프레임은 I-프레임보다 작고 더 많습니다. 변경을 위해 이전 프레임과 후속 프레임을 모두 참조하는 B-프레임(양방향 프레임)도 있습니다. IPB 프레임의 반복 패턴을 GOP(Group of Pictures)라고 합니다. I-프레임의 시간 간격은 다양하며 XNUMX초에 여러 번에서 거의 XNUMX분까지 다양합니다. 더 많은 I-프레임이 전송될수록 비디오 스트림은 더 커지지만 I-프레임에서만 발생할 수 있으므로 스트림의 디코딩을 다시 시작하는 것이 더 쉽습니다.

H.265

H.265 및 MPEG-H Part 2로도 알려진 HEVC(High-Efficiency Video Coding)는 널리 사용되는 Advanced Video Coding(AVC, H.264 또는 MPEG-4 Part 10)의 후속 제품으로 MPEG-H 프로젝트의 일부로 설계된 비디오 압축 표준입니다. AVC와 비교하여 HEVC는 동일한 수준의 비디오 품질에서 25%에서 50% 더 나은 데이터 압축을 제공하거나 동일한 비트 전송률에서 상당히 향상된 비디오 품질을 제공합니다. 8192K UHD를 포함하여 최대 4320×8의 해상도를 지원하며 주로 8비트 AVC와 달리 HEVC의 고충실도 Main 10 프로필은 거의 모든 지원 하드웨어에 통합되었습니다.

H.264vsH.265 H.265 여러 가지 이유로 인해 H.264보다 고급입니다. 여기서 가장 큰 차이점은 H.265/HEVC가 라이브 비디오 스트림의 파일 크기를 훨씬 더 작게 할 수 있다는 것입니다. 이는 필요한 대역폭을 크게 낮춥니다. 그런 다음 H.265의 또 다른 장점은 코딩 트리 단위로 데이터를 처리한다는 사실입니다. 매크로블록은 4×4에서 16×16 블록 크기까지 가능하지만 CTU는 최대 64×64 블록까지 처리할 수 있습니다. 이를 통해 H.265는 정보를 보다 효율적으로 압축할 수 있습니다. 또한, H.265는 또한 H.264보다 향상된 모션 보상 및 공간 예측을 제공합니다. 이는 장치가 모든 정보를 압축 해제하고 스트림을 시청하는 데 더 적은 대역폭과 처리 능력이 필요하다는 점에서 시청자에게 매우 유용합니다.

고정 및 가변 비트 전송률(CBR 및 VBR)

비트 전송률은 일정 기간 동안 전송되는 데이터의 양을 측정합니다. 온라인 비디오 스트리밍에서 비디오 비트 전송률은 초당 킬로비트(kbps)로 측정됩니다. 비트 전송률은 비디오 품질에 영향을 미칩니다. 더 높은 비트 전송률로 스트리밍하면 고품질 스트림을 생성하는 데 도움이 됩니다.

비트 전송률도 데이터 전송을 다루기 때문에 스트리밍 프로세스의 인코딩 또는 트랜스코딩 단계에서 중요한 것입니다.

고정 비트레이트

CBR용으로 카메라를 구성할 때 카메라는 일정한 대역폭을 사용하도록 설정됩니다. 적용되는 압축의 양은 변경 사항이 많을수록 증가합니다. 이로 인해 이미지에 압축 아티팩트가 추가되고 이미지 품질이 저하될 수 있습니다. CBR을 사용하면 대역폭 목표를 충족하기 위해 이미지 품질이 희생됩니다. 목표가 합리적으로 설정된 경우 이러한 저하가 거의 눈에 띄지 않을 수 있으며 스토리지 계산 및 네트워크 계획을 위한 안정적인 기반을 제공합니다. 네트워크 활용도가 낮거나 저장 공간이 넉넉한 LAN에 설치된 IP 감시 카메라의 경우 최상의 화질을 유지하려면 VBR을 권장하고, CBR은 대역폭이 제한된 환경을 제어하는 데 도움이 될 수 있습니다.

가변 비트레이트

각 압축 방법의 강도를 조정할 수 있습니다. 일반적으로 압축률이 높을수록 더 많은 아티팩트가 발생하므로 원하는 동작을 달성하기 위한 다양한 전략이 있습니다. VBR 압축을 사용할 때 압축된 스트림의 크기는 일관된 이미지 품질을 유지하기 위해 다양하게 허용됩니다. 따라서 VBR은 장면에 움직임이 있고 일정하지 않은 경향이 있을 때 더 적합할 수 있습니다. 단점은 대역폭이 상황에 따라 어느 정도 달라질 수 있다는 것입니다. 따라서 스토리지가 계획보다 일찍 소진되거나 카메라가 갑자기 더 많은 대역폭을 필요로 할 때 전송 병목 현상이 나타날 수 있습니다. VBR에서는 비트 전송률에 정해진 상한선이 없습니다. 사용자는 특정 목표 비트 전송률 또는 이미지 품질 수준을 설정합니다.

일부 레코더 시스템에서는 VBR 압축 수준을 Extra High, High, Normal, Low 및 Extra Low로 설정할 수 있습니다.

카메라 대역폭 소비

다음은 카메라 대역폭 소비의 몇 가지 일반적인 동인입니다.

분해능: 해상도가 높을수록 대역폭이 커집니다.

프레임 속도: 프레임 속도가 높을수록 대역폭이 커집니다.

장면 복잡성: 장면의 활동이 많을수록(많은 자동차와 사람이 움직이는 것과 장면에 아무도 없는 경우) 필요한 대역폭이 커집니다.

낮은 조명: 항상 그런 것은 아니지만 야간에는 카메라 노이즈로 인해 더 많은 대역폭이 필요합니다.

비디오 해상도

비디오 감시 시스템의 모든 카메라에는 이미지 센서가 있습니다. 왼쪽에서 오른쪽으로 사용 가능한 픽셀은 수평 해상도를 제공하고 위에서 아래로 픽셀은 수직 해상도를 제공합니다. 이 이미지 센서의 총 해상도에 두 숫자를 곱하십시오.

픽셀의 RGB 색상 값이 24비트라고 가정합니다.

1920(H) x 1080(V) = 2,073,600픽셀 = 2.0MP x 24비트 = 48Mbit/s

4096(H) x 2160(V) = 8,847,360픽셀 = 8.0MP x 24비트 = 192Mbit/s

따라서 4096 x 2160은 더 많은 픽셀, 즉 더 많은 데이터를 포함하므로 더 많은 대역폭을 사용합니다. 그러나 피사체, 얼굴 또는 자동차 모델과 색상 또는 번호판을 식별해야 할 때 더 선명하고 선명한 사진을 제공합니다. 반대로 해상도가 낮으면 대역폭이 줄어들지만 이미지가 덜 선명하고 흐릿해집니다. 낮은 해상도는 일반적으로 감시 운영자에게 상황 인식을 제공하여 세부 사항이 아닌 진행 상황을 볼 수 있습니다.

해상도만이 이미지의 선명도를 결정하는 것은 아닙니다. 렌즈의 광학 성능, 초점 거리(광학 줌), 물체까지의 거리, 조명 조건, 먼지 및 날씨도 중요한 요소입니다.

프레임 속도

비디오 감시 시스템의 프레임 속도는 초당 프레임 수(FPS)로 측정되며, 이는 60초에 생성되는 사진 수를 의미합니다. 프레임 속도가 높을수록 비디오에서 피사체가 더 부드럽게 움직입니다. 프레임 속도가 낮을수록 피사체가 중간에 있는 것을 잃고 한 위치에서 다른 위치로 점프하는 지점까지 움직임이 더 급격해집니다. 대역폭은 프레임 속도에 따라 증가합니다. 인코딩 효율이 저하되기 때문에 일반적으로 프레임 속도를 절반으로 줄여도 대역폭이 절반으로 줄어들지 않습니다. 최신 감시 카메라는 최대 30FPS를 생성할 수 있습니다. 그러나 해상도가 너무 높게 설정되면 CPU 제한으로 인해 FPS가 더 낮은 값으로 제한되는 경우가 있습니다. 장면에 대한 최적의 FPS 설정을 찾는 것은 목표 간의 절충안입니다. 프레임과 대역폭 고려 사이에서 필수 세부 사항이 손실되지 않고 모든 관련 정보를 캡처합니다. 카메라가 조용한 개요를 모니터링하는 경우 5FPS까지 올라갈 필요가 없습니다. 15~XNUMXFPS로 설정하면 충분합니다. 경험적으로 빠른 변화가 발생하거나 피사체의 움직임이 더 빠를 것으로 예상될수록 FPS를 높게 설정해야 합니다. 카메라를 설치한 후 FPS를 조정하고 비디오의 부드러움이 허용 가능한지 여부를 모니터링합니다.

장면 복잡성

장면의 복잡성은 비디오 카메라가 생성하는 대역폭에도 영향을 미칩니다. 일반적으로 장면이 복잡할수록 특정 이미지 품질을 얻기 위해 더 많은 대역폭이 필요합니다. 예를 들어 나뭇잎, 철조망 또는 팝콘 천장과 같은 임의의 텍스처가 있는 장면은 장면의 복잡성을 증가시킵니다. 일반 색상으로 칠한 벽이나 작은 디테일과 같은 다른 것들은 단순한 장면으로 간주됩니다. 마찬가지로 움직임이나 움직임은 복잡성을 증가시킵니다. 지나가는 사람, 지나가는 자동차, 산들바람에 흔들리는 나뭇잎 등이 그 예입니다.

카메라 및 클라이언트 수 카메라 수는 비디오 감시 시스템의 대역폭 요구 사항에 영향을 미칩니다. 모든 카메라가 동일한 경우 카메라 번호가 두 배가 되면 생성되는 데이터가 두 배가 됩니다. 시스템의 확장성을 유지하려면 큰 토폴로지를 관리 가능한 작은 파티션으로 나눌 수 있어야 합니다. 계층화되고 분산된 아키텍처로 시스템을 구성함으로써 많은 양의 확장성을 유지할 수 있습니다. 핵심은 대역폭을 분배하여 병목 현상을 방지하는 것입니다. 자세한 내용은 대역폭 병목 현상 섹션에서 설명합니다. 시청자 수 위의 논의는 레코더에 공급되는 카메라 대역폭과 관련이 있습니다. 이것은 그림의 한 면일 뿐이며 다른 면은 레코더를 라이브 또는 재생 비디오를 보는 클라이언트에 연결합니다. 예를 들어 하루 24시간 연중무휴 카메라를 지속적으로 모니터링하는 보안 팀이 있을 수 있습니다. 이 대역폭은 카메라에서 오는 모든 데이터와 동일합니다. 재생의 경우 라이브 스트리밍과 함께 사용한다면 더 많은 대역폭이 필요합니다. 동시에 시스템에 연결하는 많은 클라이언트가 있을 수 있다는 점을 고려하면 클라이언트 측 트래픽이 주요 관심사가 될 수 있습니다.