Die Bandbreite ist das wichtigste Element der Ethernet-Vernetzung für Videoüberwachungssysteme. Ohne sorgfältige Planung im Voraus könnte es bei den Videoüberwachungssystemen zu einem Bandbreitenengpass kommen. Dies führt nicht nur zu Videopaketverlusten, Verzögerungen oder Jitter, sondern verschlechtert auch die Videoqualität oder, noch schlimmer, verhindert die Aufzeichnung kritischer Vorfälle. Die Bandbreite bestimmt auch den Speicherkapazitätsbedarf für einen bestimmten Aufbewahrungszeitraum. Um die Videobandbreite zu verstehen, sind fundierte Kenntnisse in mehreren Bereichen erforderlich. Dieser technische Hinweis soll grundlegende Kenntnisse darüber vermitteln, welche Auswirkungen die Leistung von Videoüberwachungssystemen hat.

Was ist Bandbreite?

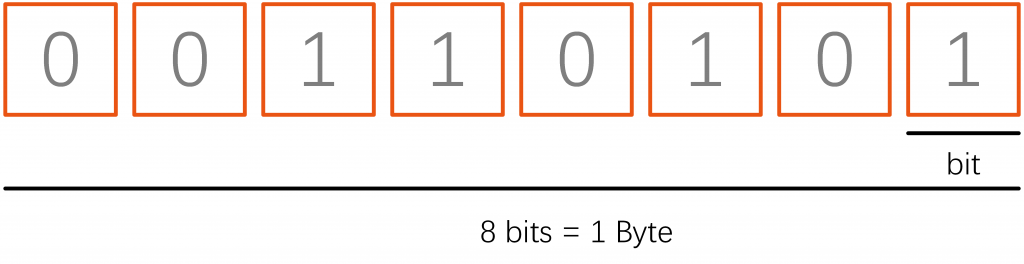

IP-Video wird als Datenstrom übertragen, der die Bild-, Audio- und Steuerdaten der Kamera enthält. Die Datenmenge, die pro Sekunde gesendet werden muss, wird als Bandbreite bezeichnet. Sie wird üblicherweise in Mbit/s gemessen und lässt sich daher leicht mit der Bitratenkapazität einer Ethernet-Verbindung vergleichen. Beispielsweise werden 10 Mbit/s als Ethernet bezeichnet, 100 Mbit/s als Fast Ethernet und 1,000 Mbit/s als Gigabit Ethernet. Eine weitere Maßeinheit ist MByte/s, was einem Achtel der Bitrate entspricht, da ein Byte 1 Bits enthält.

1 Mbit/s = 1,000 Kbit/s = 125 Kbyte/s

1 Gbit/s = 1,000 Mbit/s = 125 Mbyte/s

Eine Kamera mit einer HD-Auflösung von 1920 x 1080 erzeugt ungefähr rohe Videodaten mit 1.49 Gbit/s (30 x 1920 x 1080 x 24) für Videos mit 30 FPS. Das sind 178 MByte/s Daten und der Grund, warum eine Videokomprimierung erforderlich ist.

Bits und Bytes

In Videoüberwachungssystemen wird die Bandbreite normalerweise in Bits gemessen, manchmal jedoch auch in Bytes, was zu Verwirrung führt. 8 Bit entsprechen 1 Byte. Wenn also jemand sagt, 40 Megabit pro Sekunde, und eine andere Person, der 5 Megabyte pro Sekunde sagt, bedeutet das Gleiche, kann aber leicht missverstanden oder missverstanden werden.

Sowohl Bits als auch Bytes verwenden zur Kurzbezeichnung denselben Buchstaben. Der einzige Unterschied besteht darin, dass Bits den Kleinbuchstaben „b“ und Bytes den Großbuchstaben „B“ verwenden. Sie können sich daran erinnern, indem Sie sich daran erinnern, dass Bytes „größer“ als Bits sind. Wir sehen oft, dass Menschen dies verwechseln, weil sie auf den ersten Blick ähnlich aussehen. Zum Beispiel 100 Kb/s und 100 Kb/s, letzteres ist 8x größer als ersteres.

Wir empfehlen die Verwendung von Bits bei der Beschreibung der Bandbreite von Videoüberwachungssystemen. Beachten Sie jedoch, dass einige Personen, häufig auf der Server-/Speicherseite, Bytes verwenden. Seien Sie daher wachsam und bitten Sie um eine Bestätigung, wenn Unklarheiten bestehen (z. B. „Entschuldigen Sie, dass Sie X Bits oder Bytes gesagt haben“).

Kilobit, Megabit und Gigabit

Das Senden eines Videos erfordert viele Bits (oder Bytes). In der Praxis werden Sie nie einen Videostream mit 500 B/s oder gar 500 B/s haben. Videos benötigen im Allgemeinen mindestens Tausende oder Millionen Bits. Aggregierte Videostreams benötigen oft Milliarden von Bits.

Die gebräuchlichen Ausdrücke/Präfixe zum Ausdrücken einer großen Bandbreite sind:

- Kilobit sind Tausend, z. B. 500 Kbit/s entsprechen 500,000 Bit/s. Ein einzelner Videostream in Kilobit hat in der Regel entweder eine niedrige Auflösung oder einen niedrigen Frame oder eine hohe Komprimierung (oder alle oben genannten Punkte).

- Megabit sind Millionen, z. B. 5 Mbit/s entsprechen 5,000,000 Bit/s. Der Videostream einer einzelnen IP-Kamera liegt in der Regel im einstelligen Megabitbereich (z. B. 1 Mbit/s, 2 Mbit/s oder 4 Mbit/s sind recht übliche Bereiche). Mehr als 10 Mbit/s für einen einzelnen Videostream sind seltener, bei Modellen mit superhoher Auflösung (4K, 20 MP, 30 MP usw.) jedoch nicht unmöglich. Allerdings können 100 Kameras, die gleichzeitig gestreamt werden, routinemäßig 200 Mbit/s oder 300 Mbit/s usw. erfordern.

- Gigabit sind Milliarden, z. B. 5 Gbit/s entsprechen 5,000,000,000 Bit/s. Für die Videoüberwachung benötigt man selten mehr als ein Gigabit Bandbreite, es sei denn, man verfügt über ein sehr großes Videoüberwachungssystem, das alle Videos an einen zentralen Standort zurückleitet.

Bitraten

Bei Videoüberwachungssystemen ist die Bandbreite wie die Fahrzeuggeschwindigkeit. Es handelt sich um eine Rate im Laufe der Zeit. So wie man sagen könnte, dass man 60 Meilen pro Stunde (oder 96 km/h) gefahren ist, könnte man auch sagen, dass die Bandbreite einer Kamera 600 Kb/s beträgt, also dass 600 Kilobit pro Sekunde übertragen wurden.

Bitraten werden immer als Daten (Bits oder Bytes) pro Sekunde ausgedrückt. Angaben pro Minute oder Stunde sind nicht anwendbar, vor allem weil Netzwerkgeräte danach bewertet werden, was das Gerät pro Sekunde verarbeiten kann.

Videokomprimierung und Bandbreite

Bei der Videokomprimierung in Videoüberwachungssystemen wird eine Videodatei so kodiert, dass sie weniger Speicherplatz als die Originaldatei benötigt und einfacher über das Netzwerk/Internet übertragen werden kann. Dabei handelt es sich um eine Art Komprimierungstechnik, die die Größe von Videodateiformaten reduziert, indem redundante und nicht funktionsfähige Daten aus der Originalvideodatei entfernt werden.

Sobald ein Video komprimiert ist, wird sein ursprüngliches Format in ein anderes Format geändert (abhängig vom verwendeten Codec). Der Videoplayer muss dieses Videoformat unterstützen oder in den Komprimierungscodec integriert sein, um die Videodatei abzuspielen.

Motion JPEG

Motion JPEG (M-JPEG oder MJPEG) ist ein Videokomprimierungsformat in denen jeder Videobild or verschachtelt Feld von a digitales Video Reihenfolge ist Druckluft separat als JPEG Image.

Motion JPEG wurde ursprünglich für Multimedia-PC-Anwendungen entwickelt und verfügt über eine breite Client-Unterstützung: Die meisten gängigen Webbrowser und Player bieten native Unterstützung, für den Rest sind Plug-Ins verfügbar. Zu den Software und Geräten, die den M-JPEG-Standard verwenden, gehören Webbrowser, Mediaplayer, Spielekonsolen, Digitalkameras, IP-Kameras, Webcams, Streaming-Server, Videokameras und nichtlineare Videoeditoren

H.264

H.264, auch MPEG-4 AVC genannt, ist ein Komprimierungsstandard, der 2003 eingeführt wurde und der vorherrschende Standard für Kameras von Videoüberwachungssystemen und vielen kommerziellen Medienanwendungen ist. Im Gegensatz zum Frame-by-Frame-Ansatz von MJPEG speichert H.264 das Vollbild nur in Abständen von beispielsweise einmal pro Sekunde und kodiert die restlichen Bilder nur mit den durch Bewegung im Video verursachten Unterschieden. Vollbilder werden I-Frame (auch Index-Frame oder Intra-Frame) genannt und die Teilbilder, die nur die Differenz zum vorherigen Frame enthalten, werden P-Frame (auch Predicted Frame oder Inter-Frame) genannt. P-Frames sind kleiner und zahlreicher als I-Frames. Es gibt auch einen B-Frame (bidirektionaler Frame), der bei Änderungen in beide Richtungen auf vorherige und nachfolgende Frames verweist. Das wiederkehrende Muster von IPB-Frames wird als Bildgruppe (GOP) bezeichnet. Das Zeitintervall für I-Frames variiert und kann zwischen mehreren Sekunden und fast einer Minute liegen. Je mehr I-Frames übertragen werden, desto größer wird der Videostream, aber es erleichtert den Neustart der Decodierung eines Streams, da dies nur bei einem I-Frame erfolgen kann.

H.265

High-Efficiency Video Coding (HEVC), auch bekannt als H.265 und MPEG-H Teil 2, ist ein Videokomprimierungsstandard, der im Rahmen des MPEG-H-Projekts als Nachfolger des weit verbreiteten Advanced Video Coding (AVC, H.264 oder MPEG-4 Teil 10) entwickelt wurde. Im Vergleich zu AVC bietet HEVC eine um 25 bis 50 % bessere Datenkomprimierung bei gleicher Videoqualität oder eine deutlich verbesserte Videoqualität bei gleicher Bitrate. Es unterstützt Auflösungen bis zu 8192 x 4320, einschließlich 8K UHD, und im Gegensatz zum hauptsächlich 8-Bit-AVC wurde das Main 10-Profil von HEVC mit höherer Wiedergabetreue in fast alle unterstützende Hardware integriert.

H.264vsH.265 H.265 ist aus verschiedenen Gründen weiter fortgeschritten als H.264. Der größte Unterschied besteht darin, dass H.265/HEVC noch geringere Dateigrößen Ihrer Live-Videostreams ermöglicht. Dadurch wird die benötigte Bandbreite deutlich gesenkt. Ein weiterer Vorteil von H.265 ist die Tatsache, dass Daten in Codierungsbaumeinheiten verarbeitet werden. Obwohl Makroblöcke eine Blockgröße von 4×4 bis 16×16 haben können, sind CTUs in der Lage, bis zu 64×64 Blöcke zu verarbeiten. Dadurch kann H.265 Informationen effizienter komprimieren. zusätzlichH.265 verfügt außerdem über eine verbesserte Bewegungskompensation und räumliche Vorhersage als H.264. Das ist für Ihre Zuschauer sehr hilfreich, da ihre Geräte weniger Bandbreite und Rechenleistung benötigen, um alle Informationen zu dekomprimieren und einen Stream anzusehen.

Konstante und variable Bitraten (CBR und VBR)

Die Bitrate misst die Datenmenge, die über einen bestimmten Zeitraum übertragen wird. Beim Online-Videostreaming wird die Videobitrate in Kilobit pro Sekunde oder Kbps gemessen. Die Bitrate beeinflusst die Qualität eines Videos. Durch Streaming mit höherer Bitrate können Sie Streams mit höherer Qualität produzieren.

Die Bitrate ist auch in der Kodierungs- oder Transkodierungsphase des Streaming-Prozesses wichtig, da es hier ebenfalls um die Datenübertragung geht.

Konstante Bit-Rate

Wenn Sie eine Kamera für CBR konfigurieren, ist die Kamera auf einen konstanten Bandbreitenverbrauch eingestellt. Der Grad der angewendeten Komprimierung nimmt zu, je mehr Änderungen auftreten. Dies kann zu Komprimierungsartefakten im Bild führen und die Bildqualität beeinträchtigen. Bei CBR wird die Bildqualität geopfert, um das Bandbreitenziel zu erreichen. Wenn das Ziel angemessen festgelegt ist, ist diese Verschlechterung möglicherweise kaum spürbar und bietet eine stabile Grundlage für die Berechnung des Speichers und die Planung des Netzwerks. Bei IP-Überwachungskameras, die in einem lokalen Netzwerk (LAN) mit geringer Netzwerkauslastung oder bei reichlich Speicherplatz installiert sind, wird VBR empfohlen, um die beste Bildqualität aufrechtzuerhalten, während CBR bei der Kontrolle bandbreitenbeschränkter Umgebungen helfen kann.

Variable Bitrate

Die Stärke jeder Komprimierungsmethode kann angepasst werden. Im Allgemeinen verursacht eine höhere Komprimierung mehr Artefakte, daher gibt es unterschiedliche Strategien, um das gewünschte Verhalten zu erreichen. Bei Verwendung der VBR-Komprimierung kann die Größe des komprimierten Streams variieren, um eine gleichbleibende Bildqualität zu gewährleisten. Daher kann VBR besser geeignet sein, wenn in der Szene Bewegung vorhanden ist und diese tendenziell nicht konstant ist. Der Nachteil besteht darin, dass die Bandbreite je nach Situation bis zu einem gewissen Grad variieren kann. So kann der Speicher früher als geplant aufgebraucht sein oder es kann zu Übertragungsengpässen kommen, wenn Kameras plötzlich mehr Bandbreite benötigen. Bei VBR gibt es keine feste Obergrenze für die Bitrate. Der Benutzer legt eine bestimmte Zielbitrate oder Bildqualitätsstufe fest.

Bei einigen Rekordersystemen kann die VBR-Komprimierungsstufe auf „Extra Hoch“, „Hoch“, „Normal“, „Niedrig“ und „Extra Niedrig“ eingestellt werden.

Kamerabandbreitenverbrauch

Hier sind einige häufige Ursachen für den Bandbreitenverbrauch von Kameras:

Auflösung: Je höher die Auflösung, desto größer die Bandbreite.

Frame Rate: Je höher die Bildrate, desto größer die Bandbreite

Komplexität der Szene: Je mehr Aktivität in der Szene (viele Autos und Menschen in Bewegung, aber niemand in der Szene), desto größer ist die erforderliche Bandbreite.

wenig Licht: Nachts ist aufgrund von Kamerarauschen oft, aber nicht immer, mehr Bandbreite erforderlich.

Video-Auflösung

Jede Kamera in Videoüberwachungssystemen verfügt über einen Bildsensor. Die verfügbaren Pixel von links nach rechts liefern die horizontale Auflösung, während die Pixel von oben nach unten die vertikale Auflösung liefern. Multiplizieren Sie die beiden Zahlen, um die Gesamtauflösung dieses Bildsensors zu erhalten.

Angenommen 24 Bit für die RGB-Farbwerte eines Pixels:

1920 (H) x 1080 (V) = 2,073,600 Pixel = 2.0 MP x 24 Bit = 48 Mbit/s

4096 (H) x 2160 (V) = 8,847,360 Pixel = 8.0 MP x 24 Bit = 192 Mbit/s

Daher benötigt 4096 x 2160 mehr Bandbreite, da es mehr Pixel oder einfach mehr Daten enthält. Aber es liefert klarere und schärfere Bilder, wenn es nötig ist, ein Motiv, ein Gesicht, ein Automodell und seine Farbe oder sein Nummernschild zu identifizieren. Umgekehrt erzeugt eine niedrigere Auflösung weniger Bandbreite, aber der Nachteil ist ein weniger klares, unschärferes Bild. Eine niedrigere Auflösung verschafft Überwachungsmitarbeitern in der Regel ein Situationsbewusstsein – sie sehen eher, was vor sich geht, als Details.

Die Auflösung ist nicht das Einzige, was die Klarheit eines Bildes bestimmt. Auch die optische Leistung des Objektivs, die Brennweite (optischer Zoom), der Abstand zum Objekt, Lichtverhältnisse, Schmutz und Wetter sind entscheidende Faktoren.

Frame Rate

Die Bildrate in Videoüberwachungssystemen wird in Bildern pro Sekunde (FPS) gemessen, was die Anzahl der Bilder bedeutet, die in einer Sekunde produziert werden. Je höher die Bildrate, desto flüssiger bewegt sich das Motiv im Video. Je niedriger die Bildrate, desto ruckartiger werden die Bewegungen, bis hin zu dem Punkt, an dem die Motive von Position zu Position springen und alles dazwischen verloren geht. Die Bandbreite erhöht sich mit der Bildrate. Allerdings führt die halbe Bildrate in der Regel nicht zu einer Halbierung der Bandbreite, da die Kodierungseffizienz darunter leidet. Moderne Überwachungskameras können bis zu 60 FPS erzeugen. Aufgrund von CPU-Einschränkungen wird die FPS jedoch manchmal auf einen niedrigeren Wert begrenzt, wenn die Auflösung zu hoch eingestellt ist. Das Finden der optimalen FPS-Einstellung für eine Szene ist ein Kompromiss zwischen den Zielen: Erfassen aller relevanten Informationen, ohne dass wesentliche Details zwischen den Bildern verloren gehen, und Überlegungen zur Bandbreite. Wenn eine Kamera einen ruhigen Überblick überwacht, ist es nicht erforderlich, die Geschwindigkeit auf 30 FPS zu erhöhen. Eine Einstellung von 5 bis 15 FPS ist ausreichend. Als Faustregel gilt: Je schneller Änderungen auftreten oder je schnellere Bewegungen des Motivs erwartet werden, desto höher sollte die FPS eingestellt werden. Passen Sie die FPS nach der Installation der Kameras an und überwachen Sie, ob die Glätte des Videos akzeptabel ist oder nicht.

Komplexität der Szene

Die Komplexität einer Szene beeinflusst auch die Bandbreite, die eine Videokamera erzeugt. Generell gilt: Je komplexer die Szene, desto mehr Bandbreite wird benötigt, um eine bestimmte Bildqualität zu erreichen. Beispielsweise erhöhen Szenen mit Baumblättern, Drahtzäunen oder zufälligen Texturen wie Popcorndecken die Komplexität der Szene. Andere, wie eine normale, einfarbig gestrichene Wand oder ein kleines Detail, werden als einfache Szene betrachtet. Ebenso erhöht Bewegung oder Bewegung die Komplexität. Beispiele dafür sind vorbeigehende Menschen, vorbeifahrende Autos oder Baumblätter im Wind.

Anzahl der Kameras und Clients Die Anzahl der Kameras beeinflusst den Bandbreitenbedarf eines Videoüberwachungssystems. Wenn alle Kameras gleich sind, verdoppeln sich die generierten Daten, wenn die Kameranummern verdoppelt werden. Um die Skalierbarkeit eines Systems aufrechtzuerhalten, muss es in der Lage sein, große Topologien in überschaubare kleinere Partitionen aufzuteilen. Durch die Strukturierung des Systems in einer geschichteten und verteilten Architektur ist es möglich, die Skalierbarkeit über einen großen Mengenbereich aufrechtzuerhalten. Der Schlüssel liegt darin, die Bandbreite so zu verteilen, dass Engpässe vermieden werden. Weitere Informationen finden Sie im Abschnitt „Bandbreitenengpässe“. Anzahl der anzeigenden Kunden Die obige Diskussion bezieht sich auf die Einspeisung der Kamerabandbreite in den Rekorder. Dies ist nur eine Seite des Bildes, während auf der anderen Seite die Rekorder mit den Clients verbunden werden, die Live- oder Wiedergabevideos ansehen. Beispielsweise könnte es ein Sicherheitsteam geben, das die Kameras rund um die Uhr und sieben Tage die Woche ständig überwacht. Diese Bandbreite würde allen von den Kameras kommenden Daten entsprechen. Bei der Wiedergabe zusätzlich zum Live-Streaming ist noch mehr Bandbreite erforderlich. Wenn man bedenkt, dass viele Clients gleichzeitig eine Verbindung zu einem System herstellen können, kann der clientseitige Datenverkehr das Hauptproblem darstellen.